[ad_1]

tudo sobre ChatGPT

tudo sobre Inteligência Artificial

tudo sobre OpenAI

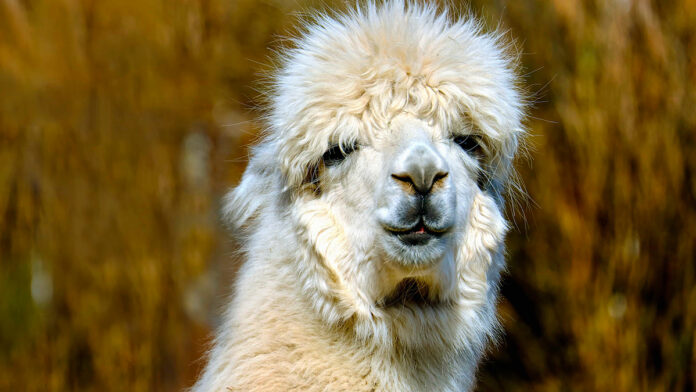

Pesquisadores da Universidade de Stanford, nos EUA, lançaram o Alpaca, modelo de IA (inteligência artificial) quase igual ao ChatGPT. A diferença principal foi o custo para treiná-lo: apenas US$ 600 (R$ 3,1 mil, na conversão atual).

Aliás, o pesquisador – que trabalha no CRFM (Centro de Pesquisa em Modelos Fundamentais) da universidade – disse que custou “tudo” isso porque não orientou seu processo. Ou seja, treine modelos futuros agora sairia mais barato ainda.

Leia mais:

Importância da Alpaca

Até o ChatGPT da OpenAI chegar ao público, em novembro de 2022, os LLMs (“Large Language Models” ou “Modelos Grandes de Linguagem”, em tradução livre) eram um tópico de discussão entre os pesquisadores de IA.

Além disso, a OpenAI gastou milhões de dólares treinando-os para se certificar que o ChatGPT forneceria respostas às perguntas humanas da mesma forma que outro humano responderia. Junte isso aos investimentos bilionários da Microsoft na OpenAI e pronto: fica claro (aparentemente) que treinamento de modelos de IA é tão difícil quanto caro.

Pesquisadores de Stanford criaram uma espécie de clone do ChatGPT com orçamento modesto é importante, neste contexto, porque abre caminho para outras empresas de IA saírem das garagens.

Como treinaram o clone do ChatGPT

Um componente importantíssimo dessa conquista foi o LLaMA 7B, um modelo de linguagem de código aberto, ao qual o pesquisador teve acesso. Curiosamente, esse modelo vem da Meta (dona do Facebook, Instagram e WhatsApp) e é um dos menores e mais baratos disponíveis atualmente.

Porém, os recursos internos neste modelo não chegam nem perto dos níveis do ChatGPT. Então, os investigadores então seguiram ao GPT, IA por trás do chatbot, e usaram uma API (Interface de Programação de Aplicativo) para usar 175 pares de instrução/saída escrita por humanos para gerar mais no mesmo estilo e formato.

Gerando 20 dessas declarações por vez, os investigadores coletaram 52 mil conversas de amostra em pouquíssimo tempo, o que lhes custou US$ 500 (R$ 2,6 mil). Este conjunto de dados foi então usado no pós-treino do modelo LLaMa. Passando para oito computadores de processamento em nuvem A100 de 80 GB, os pesquisadores concluíram essa tarefa em apenas três horas, gastando menos de US$ 100 (R$ 524).

Por fim, o modelo treinado, apelidado de Alpaca, foi testado contra o próprio ChatGPT em vários domínios. E venceu o GPT em seu próprio jogo. Ainda segundo o pesquisador, dava para obter melhores resultados se respirado usado o GPT-4, a versão mais recente da IA.

Democratizando conhecimento

Os investigadores já divulgaram as 52 mil perguntas usadas na pesquisa, junto ao código usado para gerá-las. Graças a isso, outras pessoas poderão repetir o processo e replicar os resultados.

Porém, a IA e suas respostas não estão sujeitas à proteção assegurada pela OpenAI ao seu chatbot. Por isso, pode-se esperar algumas respostas atendidas.

Com informações de Engenharia interessante

Imagem de destaque: Couleur / Pixnio

Já assistiu aos novos vídeos no YouTube do Olhar Digital? Inscreva-se no canal!

[ad_2]

Olhar Digital